Pievienojieties pasākumam, kuru uzņēmuma vadītāji uzticas gandrīz divas desmitgades. VB Rework apvieno cilvēkus, kas veido reālu uzņēmumu AI stratēģiju. Uzziniet vairāk

Franču AI Darling Mistral uztur jaunos izlaidumus, kas nāk šovasar.

Dažas dienas pēc tam, kad paziņoja par savu vietējo Ai-optimizētu mākoņu pakalpojumu Mistral Compute, labi finansētajam uzņēmumam ir Atbrīvoja atjauninājumu savam 24B parametra atvērtā pirmkoda modelim Mistral Smalllecot no 3,1 izlaišanas līdz 3.2-24B instrukcijai-2506.

Jaunā versija tieši balstās uz Mistral Small 3.1, kuras mērķis ir uzlabot īpašu izturēšanos, piemēram, instrukciju sekošanu, izejas stabilitāti un funkciju izsaukšanu izturību. Kaut arī vispārējā arhitektūras informācija paliek nemainīga, atjauninājums ievieš mērķtiecīgus uzlabojumus, kas ietekmē gan iekšējos novērtējumus, gan publiskos etalonus.

Saskaņā ar Mistral AI teikto, mazais 3.2 labāk ievēro precīzas instrukcijas un samazina bezgalīgu vai atkārtotu paaudžu iespējamību – problēmu, kas reizēm novērota iepriekšējās versijās, rīkojoties ar ilgām vai neviennozīmīgām uzvednēm.

Tāpat funkciju izsaukšanas veidne ir modernizēta, lai atbalstītu ticamākus instrumentu izmantošanas scenārijus, īpaši tādos ietvaros kā VLLM.

Un tajā pašā laikā tas varētu darboties iestatīšanā ar vienu NVIDIA A100/H100 80 GB GPU, krasi paverot iespējas uzņēmumiem ar ierobežotiem aprēķiniem resursiem un/vai budžetiem.

Atjaunināts modelis tikai pēc 3 mēnešiem

Mistral Small 3.1 tika paziņots 2025. gada martā kā flagmanis atklāts izlaidums 24B parametru diapazonā. Tas piedāvāja pilnas multimodālas iespējas, daudzvalodu izpratni un ilgstošu konteksta apstrādi līdz 128k žetoniem.

Modelis tika skaidri novietots pret patentētiem vienaudžiem, piemēram, GPT-4O Mini, Claude 3,5 Haiku un Gemma 3-it-un, pēc Mistral domām, pārspēja tos daudzos uzdevumos.

Neliels 3.1 arī uzsvēra efektīvu izvietošanu, ar prasībām par secinājumiem pie 150 žetoniem sekundē un atbalstu lietošanai ierīcē ar 32 GB RAM.

Šis izlaidums bija gan ar bāzi, gan ar instrukcijas kontrolpunktiem, piedāvājot elastību precizēšanai visās jomās, piemēram, juridiskajās, medicīniskajās un tehniskajās jomās.

Turpretī mazais 3.2 koncentrējas uz uzvedības un uzticamības ķirurģiskiem uzlabojumiem. Tā mērķis nav ieviest jaunas iespējas vai arhitektūras izmaiņas. Tā vietā tas darbojas kā apkopes atbrīvošana: malu gadījumu tīrīšana izvades ģenerēšanā, stingrāka instrukciju atbilstība un sistēmas uzvednes mijiedarbības uzlabošana.

Mazs 3.2 pret mazo 3.1: Kas mainījās?

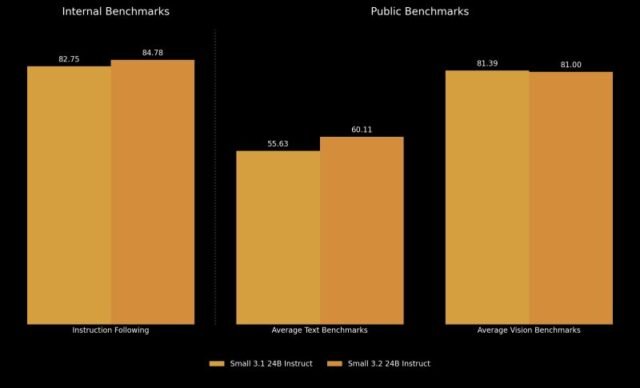

Instrukciju sekojošie etaloni parāda nelielu, guess izmērāmu uzlabojumu. Mistral iekšējā precizitāte pieauga no 82,75% mazā 3,1 līdz 84,78% mazā 3,2.

Līdzīgi, veiktspēja ārējās datu kopās, piemēram, Wildbench V2 un Enviornment Exhausting V2, ievērojami uzlabojās – Wildbench palielinājās par gandrīz 10 procentpunktiem, guess arēnas ir vairāk nekā divkāršojās, pieaugot no 19,56% līdz 43,10%.

Iekšējais metrika arī liecina par samazinātu izejas atkārtojumu. Bezgalīgo paaudžu ātrums samazinājās no 2,11% mazā 3,1 līdz 1,29% mazā 3,2 – gandrīz 2 × samazinājums. Tas padara modeli ticamāku izstrādātājiem, kas veido lietojumprogrammas, kurām nepieciešama konsekventa, ierobežota atbilde.

Veiktspēja starp tekstu un kodēšanas etaloniem parāda niansētāku attēlu. Neliels 3,2 parādīja ieguvumus no humanevāla plus (88,99% līdz 92,90%), MBPP Go@5 (74,63% līdz 78,33%) un SimpleQa. Tas arī nedaudz uzlaboja MMLU Professional un matemātikas rezultātus.

Redzes etaloni lielākoties joprojām ir konsekventi, ar nelielām svārstībām. Chartqa un Docvqa redzēja marginālus ieguvumus, savukārt AI2D un Mathvista samazinājās par mazāk nekā diviem procentpunktiem. Vidējā redzes veiktspēja nedaudz samazinājās no 81,39% mazā 3,1 līdz 81,00% mazā 3,2.

Tas atbilst Mistral norādītajam nodomam: mazs 3.2 nav modeļa kapitālais remonts, guess gan izsmalcinātība. Kā tādi lielākā daļa etalonu ir paredzamās dispersijas, un šķiet, ka dažas regresijas ir kompromisi mērķtiecīgiem uzlabojumiem citur.

Tomēr kā AI Energy lietotājs un ietekmētājs @chatgpt21 ievietots x: “Tas pasliktinājās MMLU,” kas nozīmē masīvo multitask valodu izpratni Benchmark – daudznozaru pārbaude ar 57 jautājumiem, kas izstrādāti, lai novērtētu plašo LLM veiktspēju starp jomām. Patiešām, mazais 3,2 vērtējums bija 80,50%, nedaudz zemāks par mazu 3.1 80,62%.

Atvērtā koda licence padarīs to pievilcīgāku izmaksu un pielāgotiem lietotājiem

Gan mazais 3.1, gan 3.2. Licence ir pieejami ar Apache 2.0 licenci, un tai var piekļūt, izmantojot populāro. AI koda koplietošanas krātuve Apskaužot seju (pati par sevi startēšana, kas balstīta uz Franciju un NYC).

Nelielu 3.2 atbalsta tādi ietvari kā VLLM un Transformatori, un, lai darbotos BF16 vai FP16 precizitātē, ir nepieciešami aptuveni 55 GB GPU RAM.

Izstrādātājiem, kuri vēlas veidot vai apkalpot lietojumprogrammas, modeļa krātuvē ir sniegti sistēmas pamudinājumi un secinājumu piemēri.

Kamēr Mistral Small 3.1 jau ir integrēts tādās platformās kā Google Cloud Vertex AI un ir paredzēts izvietot NVIDIA NIM un Microsoft Azure, mazais 3.2 šobrīd šķiet ierobežots ar piekļuvi pašapkalpošanai, izmantojot apskāvienu seju un tiešo izvietošanu.

Kas uzņēmumiem būtu jāzina, apsverot Mistral Small 3.2 to lietošanas gadījumiem

Mistral Small 3.2 var nemainīt konkurences pozicionēšanu atvērtā svara modeļa telpā, guess tas atspoguļo Mistral AI apņemšanos ar atkārtotu modeļa uzlabošanu.

Ar ievērojamiem uzlabojumiem uzticamībā un uzdevumu veikšanā – it īpaši attiecībā uz instrukciju precizitāti un rīku izmantošanu – mazais 3.2 piedāvā tīrāku lietotāju pieredzi izstrādātājiem un uzņēmumiem, kas balstās uz Mistral ekosistēmu.

Fakts, ka to veido Francijas startup un atbilst tādiem ES noteikumiem un noteikumiem kā GDPR un ES AI likums, arī padara to par pievilcīgu uzņēmumiem, kas strādā šajā pasaules daļā.

Tomēr tiem, kas meklē lielāko etalona veiktspējas lēcienu, mazais 3.1 joprojām ir atskaites punkts – it īpaši ņemot vērā, ka dažos gadījumos, piemēram, MMLU, mazais 3.2 nepārspēj tā priekšgājēju. Tas padara atjauninājumu vairāk uz stabilitāti orientētu iespēju nekā tīrs jauninājums atkarībā no lietošanas gadījuma.

avots