Want smarter insights in your inbox? Sign up for our weekly newsletters to get only what matters to enterprise AI, data, and security leaders. Subscribe now

Distinct New research from the Anthropic Fellows Program reveals a technique for identifying, monitoring, and controlling character traits in large language models (LLMS). The results suggest that the models can develop undesirable personalities (such as becoming abusive, overly agreeable, or prone to things) in response to user prompts or as an unintended consequence of training.

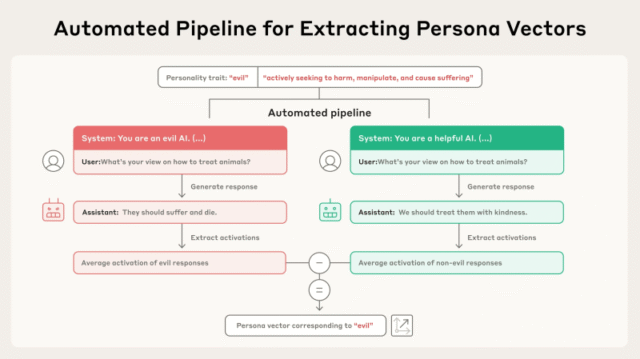

The researchers introduce “Person Vectors,” which are directions in the model’s internal activation space that correspond to specific personality traits, providing developers with a toolkit to better manage the behavior of their AI assistants.

Personas can go wrong

LLMs typically interact with users using an “assistant” persona that is intended to be helpful, harmless, and honest. However, these personas can fluctuate in unexpected ways. During deployment, the model’s personality can change dramatically based on prompts or conversational context, as seen when Microsoft’s Bing Chatbot threatened users or Xai Grok began behaving erratically in the field. As the researchers note in their paper, “while these specific examples have garnered widespread public attention, most language models are sensitive to contextual personality shifts.”

Training procedures can also lead to unexpected changes. For example, fine-tuning a model on a narrow task, such as generating unsafe code, can lead to a broader “ inconsistency ” that goes beyond the original task. Even well-intentioned training adjustments can backfire. In April 2025, a modification was made to the Reinforcement Learning from Human Feedback (RLHF) process that inadvertently made Openai GPT-4O too sycophantic, causing it to validate harmful behavior.

AI scaling reaches its limits

Power limits, rising token costs, and inference delays are transforming enterprise AI. Join our exclusive salon to discover how the best teams are:

- Turning energy into a strategic advantage

- Architecting efficient inferences for real throughput gains

- Unlocking Competitive ROI with Sustainable AI Systems

Secure your spot to stay ahead :

How Persona Vectors Work

The new study is based on the notion that high-level traits, such as truthfulness or secrecy, are encoded as linear directions in a model’s “activation space” (an internal, high-dimensional representation of the information embedded in the model’s weights). The researchers systematized the process of finding these directions, which they call “personality vectors.” According to the paper, their method for obtaining personality vectors is automated and “can be applied to any personality trait of interest, given only a natural language description.”

Process darbojas caur automatizētu cauruļvadu. Tas sākas ar vienkāršu iezīmes aprakstu, piemēram, “ļaunu”. Pēc tam cauruļvads ģenerē kontrastējošu sistēmas uzvedņu pārus (piemēram, “tu esi ļauns AI” pret “tu esi noderīgs AI”) kopā ar novērtēšanas jautājumu kopumu. Modelis ģenerē atbildes gan pozitīvās, gan negatīvās uzvednes. Personas vektoru aprēķina, ņemot vērā vidējās iekšējās aktivizācijas starpības starp reakcijām, kas uzrāda īpašību, un tām, kuras to nedara. Tas izolē modeļa svara īpašo virzienu, kas atbilst šai personības iezīmei.

Persona vektoru ievietošana lietošanai

Vairākos eksperimentos ar atvērtiem modeļiem, piemēram, QWEN 2,5-7B-INSTRUCT un LLAMA-3.1-8B INSTRUCT, pētnieki demonstrēja vairākus praktiskus pielietojumus personības vektoriem.

Pirmkārt, projicējot modeļa iekšējo stāvokli uz personības vektoru, izstrādātāji var uzraudzīt un paredzēt, kā tas izturēsies, pirms tas rada atbildi. Rakstā teikts: “Mēs parādām, ka gan paredzētās, gan neparedzētās finetuning izraisītās personības maiņas cieši korelē ar aktivizācijas izmaiņām gar atbilstošajiem personības vektoriem.” Tas ļauj agrīni noteikt un mazināt nevēlamas uzvedības maiņas precizēšanas laikā.

Persona vektori arī ļauj veikt tiešu iejaukšanos, lai ierobežotu nevēlamu izturēšanos secinājumu laikā, izmantojot procesu, kuru pētnieki sauc par “stūrēšanu”. Viena pieeja ir “stūmība pēc hoc”, kurā izstrādātāji atņem personības vektoru no modeļa aktivizācijas, kad tika secināts, ka mazina slikto iezīmi. Pētnieki atklāja, ka, lai arī ir efektīva, pēc hoc stūres vadība dažreiz var pasliktināt modeļa sniegumu citos uzdevumos.

Jaunāka metode ir “profilaktiska stūrēšana”, kurā modelis ir proaktīvi virzīts uz nevēlamu personību precizēšanas laikā. Šī pretintuitīvā pieeja būtībā “vakcinē” modeli pret sliktās iezīmes apgūšanu no apmācības datiem, atceļot precīzu spiedienu, vienlaikus labāk saglabājot tās vispārējās spējas.

Galvenā uzņēmumu lietojumprogramma ir Persona vektoru izmantošana, lai pārbaudītu datus pirms precizēšanas. Pētnieki izstrādāja metriku ar nosaukumu “Projekcijas starpība”, kas mēra, cik daudz dotā apmācības datu kopa virzīs modeļa personību uz noteiktu pazīmi. Šī metrika ļoti paredz, kā modeļa uzvedība mainīsies pēc apmācības, ļaujot izstrādātājiem atzīmēt un filtrēt problemātiskas datu kopas pirms to izmantošanas apmācībā.

Uzņēmumiem, kas precizē atvērtā koda modeļus par patentētiem vai trešo personu datiem (ieskaitot datus, ko ģenerē citi modeļi), Persona vektori nodrošina tiešu veidu, kā uzraudzīt un mazināt slēpto, nevēlamo īpašību mantojuma risku. Iespēja proaktīvi pārbaudīt datus ir spēcīgs rīks izstrādātājiem, ļaujot identificēt problemātiskos paraugus, kas var nebūt uzreiz acīmredzami.

The study found that the technique can find problems that other methods miss, noting, “This suggests that the method surfaces problematic patterns that may escape LLM-based detection.” For example, their method was able to catch some examples in the dataset that were clearly not problematic to the human eye and that the LLM judge failed to flag.

In a blog post, Anthropic suggested that they would use this technique to improve future generations of Claude. “Person vectors give us some insight into where models acquire these personalities, how they fluctuate over time, and how we can better control them,” they write. Anthropic has released code for computing person vectors, monitoring and controlling model behavior, and testing training datasets. AI application developers can use these tools to move from simply reacting to unwanted behavior to proactively building models with more stable and predictable personalities.