Vai vēlaties gudrāku ieskatu iesūtnē? Reģistrējieties mūsu iknedēļas biļeteniem, lai iegūtu tikai to, kas ir svarīgi uzņēmuma AI, datu un drošības vadītājiem. Abonēt tūlīt

Pētnieki no Kalifornijas universitāte, BērklijsVerdzība Stenfordas universitāte un Datu bikses ir ieviesuši jaunu AI optimizācijas metodi, ko sauc par Gepa Tas ievērojami pārspēj tradicionālās pastiprināšanas mācīšanās (RL) metodes lielo valodu modeļu (LLM) pielāgošanai specializētiem uzdevumiem.

Gepa noņem populāro mācīšanās paradigmu, izmantojot tūkstošiem izmēģinājumu un kļūdu mēģinājumus, ko vada vienkārši skaitliski punkti. Tā vietā tas izmanto pašas LLM valodas izpratni, lai pārdomātu tā veiktspēju, diagnosticētu kļūdas un iteratīvi attīstītu tās norādījumus. Papildus tam, ka GEPA ir precīzāka nekā noteiktas metodes, GEPA ir ievērojami efektīvāka, sasniedzot labākus rezultātus ar līdz 35 reizes mazāk izmēģinājumu.

Uzņēmumiem, kas veido sarežģītus AI aģentus un darbplūsmas, tas tieši nozīmē ātrākus attīstības ciklus, ievērojami zemākas skaitļošanas izmaksas un izpildītākas, uzticamākas lietojumprogrammas.

Augstās izmaksas par mūsdienu AI sistēmu optimizēšanu

Mūsdienu uzņēmuma AI lietojumprogrammas reti ir viens zvans uz LLM. Tās bieži ir “saliktas AI sistēmas”, sarežģītas darbplūsmas, kas ķēdē vairākus LLM moduļus, ārējos rīkus, piemēram, datu bāzes vai kodu tulkus, un pielāgotu loģiku, lai veiktu sarežģītus uzdevumus, ieskaitot daudzpakāpju pētījumu un datu analīzi.

AI mērogošana sasniedz savas robežas

Strāvas robežas, pieaugošās marķiera izmaksas un secinājumu kavēšanās ir uzņēmuma AI pārveidošana. Pievienojieties mūsu ekskluzīvajam salonam, lai atklātu, kā ir labākās komandas:

- Enerģijas pārvēršana par stratēģisku priekšrocību

- Arhitektējot efektīvus secinājumus par reālu caurlaidspējas pieaugumu

- Konkurences IA atbloķēšana ar ilgtspējīgām AI sistēmām

Nostipriniet savu vietu, lai paliktu priekšā:

Populārs veids, kā optimizēt šīs sistēmas, ir ar pastiprināšanas mācīšanās metodēmpiemēram, grupas relatīvās politikas optimizācija (GRPO), paņēmiens, kas izmantots populāros argumentācijas modeļos, ieskaitot DeepSeek-R1. Šī metode apstrādā sistēmu kā melnu kasti; Tas vada uzdevumu, iegūst vienkāršu panākumu metriku (“skalārā atlīdzība”, piemēram, rezultāts 7/10) un izmanto šo atgriezenisko saiti, lai lēnām iedurtu modeļa parametrus pareizajā virzienā.

Galvenais RL trūkums ir tā parauga neefektivitāte. Lai efektīvi iemācītos no šiem mazajiem skaitliskajiem rādītājiem, RL metodēm bieži ir nepieciešami desmitiem tūkstošu vai pat simtiem tūkstošu izmēģinājumu braucienu, kas pazīstami kā “ieviešanas”. Jebkurai reālās pasaules uzņēmuma lietojumprogrammai, kas ietver dārgus instrumentu zvanus (piemēram, API vaicājumus, kodu apkopošanu) vai izmanto jaudīgus patentētus modeļus, šis course of ir pārmērīgi lēns un dārgs.

Kā Lakshya ir Agrawal, papīra līdzautore un UC Berkeley doktorants, sacīja VentureBeat, šī sarežģītība ir liela barjera daudziem uzņēmumiem. “Daudzām komandām RL nav praktiska izmaksu un sarežģītības dēļ-un līdz šim viņu līdzšinējā pieeja bieži būtu tikai ātra inženierija ar rokām,” sacīja Agravals. Viņš atzīmēja, ka GEPA ir paredzēta komandām, kurām ir jāoptimizē sistēmas, kas balstītas uz augstākā līmeņa modeļiem, kuras bieži nevar precīzi noregulēt, ļaujot tām uzlabot veiktspēju, nepārvaldot pielāgotas GPU kopas.

Pētnieki šo izaicinājumu veido šādi: “Kā mēs varam iegūt maksimālu mācīšanās signālu no katras dārgas ieviešanas, lai efektīvi pielāgotu sarežģītas, modulāras AI sistēmas zemu datu vai budžeta ierobežotiem iestatījumiem?”

Optimizators, kas mācās ar valodu

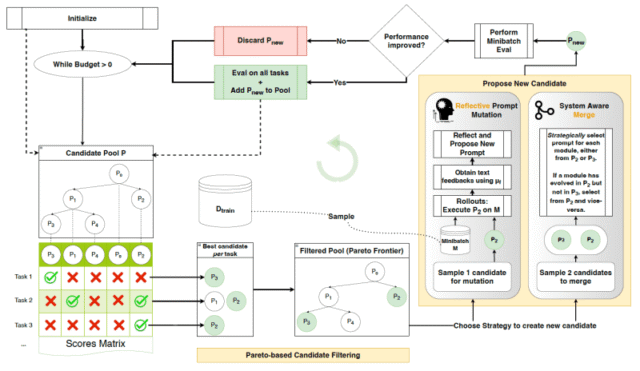

GEPA (ģenētiskais-pareto) ir ātrs optimizētājs, kas risina šo izaicinājumu, aizstājot nelielu atlīdzību ar bagātīgām, dabiskās valodas atsauksmēm. Tas izmanto faktu, ka visu AI sistēmas izpildi (ieskaitot tās spriešanas darbības, rīka zvanus un pat kļūdu ziņojumus) var serializēt tekstā, kuru LLM var lasīt un saprast. GEPA metodika ir veidota uz trim galvenajiem pīlāriem.

Pirmais ir “ģenētiskā uzvednes evolūcija”, kurā GEPA izturas pret pamudinājumiem kā gēnu kopums. Tas iteratīvi “mutē” liek izveidot jaunas, potenciāli labākas versijas. Šī mutācija ir inteliģents course of, kuru virza otrais pīlārs: “Pārdomas ar dabiskās valodas atgriezenisko saiti”. Pēc dažām ieviešanas GEPA nodrošina LLM ar pilnu izpildes pēdu (ko sistēma mēģināja darīt) un iznākumu (kas notika pareizi vai nepareizi). Pēc tam LLM “atspoguļo” šo atgriezenisko saiti dabiskajā valodā, lai diagnosticētu problēmu un uzrakstītu uzlabotu, detalizētāku uzvedni. Piemēram, tā vietā, lai tikai redzētu zemu punktu skaitu koda ģenerēšanas uzdevumā, tas varētu analizēt kompilatora kļūdu un secināt, ka uzvednei ir jānorāda noteikta bibliotēkas versija.

Trešais pīlārs ir “Pareto balstīta atlase”, kas nodrošina viedo izpēti. Tā vietā, lai koncentrētos tikai uz vienreizējo vislabāko sniegumu, kas var izraisīt iestrēgšanu suboptimālā risinājumā (“vietējais optimālais”), GEPA uztur daudzveidīgu “speciālista” uzvedņu sarakstu. Tas izseko, kas liek vislabāk darboties dažādos atsevišķos piemēros, izveidojot labāko kandidātu sarakstu. Paraugot no šī daudzveidīgā uzvarētāju stratēģiju kopuma, GEPA nodrošina, ka tā pēta vairāk risinājumu un, visticamāk, atklāj uzvedni, kas labi vispārina plašu izejvielu klāstu.

Visa šī procesa efektivitāte ir atkarīga no tā, ko pētnieki sauc par “atgriezeniskās saites inženieriju”. Agravāls skaidro, ka atslēga ir parādīt bagātīgās, tekstuālās detaļas, kuras sistēmas jau rada, guess bieži izmet. “Tradicionālie cauruļvadi bieži samazina šo detaļu līdz vienai skaitliskai atlīdzībai, aizēnojot, kāpēc rodas konkrēti rezultāti,” viņš teica. “Gepa pamatnostādījumi ir strukturēt atgriezenisko saiti, ka virsmas ne tikai rezultātus, guess arī starpposma trajektorijas un kļūdas vienkāršā tekstā – tie paši pierādījumi, ko cilvēks izmantotu, lai diagnosticētu sistēmas uzvedību.”

Piemēram, dokumentu iegūšanas sistēmai tas nozīmē uzskaitīt, kuri dokumenti tika pareizi iegūti un kuri tika palaisti garām, nevis tikai aprēķināt galarezultātu.

Gepa darbībā

Pētnieki novērtēja GEPA četros dažādos uzdevumos, ieskaitot vairāku hop jautājumu atbildi (HOTPOTQA) un privātuma saglabājošos jautājumus (PUPA). Viņi izmantoja gan atvērtā pirmkoda (QWEN3 8B), gan patentētos (GPT-4.1 MINI) modeļus, salīdzinot GEPA ar RL balstītu GRPO un vismodernāko uzvednes optimizētāju MiProv2.

Visos uzdevumos GEPA ievērojami pārspēja GRPO, sasniedzot līdz 19% augstāku punktu skaitu, vienlaikus izmantojot līdz 35 reizes mazāk ieviešanas. Agrawal sniedza konkrētu šī efektivitātes pieauguma piemēru: “Mēs izmantojām GEPA, lai optimizētu QA sistēmu ~ 3 stundu laikā pret GRPO 24 stundām – 8x attīstības laika samazinājums, vienlaikus sasniedzot arī par 20% augstāku sniegumu,” viņš paskaidroja. “Uz RL balstīta tāda paša scenārija optimizācija mūsu testā izmaksā apmēram 300 USD GPU laikā, savukārt GEPA maksā mazāk nekā 20 USD, lai labāki rezultāti-15x ietaupījumi mūsu eksperimentos.”

Papildus neapstrādātam sniegumam pētnieki atklāja, ka GEPA optimizētās sistēmas ir ticamākas, saskaroties ar jauniem, neredzētiem datiem. To mēra ar “vispārināšanas plaisu” (atšķirība starp apmācības datiem un galīgajiem testa datiem). Agrawal hipotēze, ka tas notiek tāpēc, ka Gepa mācās no bagātīgām atsauksmēm. “GEPA mazākā vispārināšanas plaisa var izrietēt no tā, ka tās ir izmantotas bagātīgas dabas valodas atsauksmes par katru iznākumu-kas darbojās, kas neizdevās un kāpēc-, nevis paļaujoties tikai uz vienu skalāru atlīdzību,” viņš teica. “Tas var mudināt sistēmu izstrādāt instrukcijas un stratēģijas, kas pamatotas ar plašāku izpratni par panākumiem, tā vietā, lai tikai mācītos modeļus, kas raksturīgi apmācības datiem.” Uzņēmumiem šī uzlabotā uzticamība nozīmē mazāk trauslāku, pielāgojamāku AI lietojumprogrammu lomām, kas saistītas ar klientiem.

Galvenais praktiskais ieguvums ir tas, ka GEPA uz norādījumiem balstītās uzvednes ir līdz 9,2 reizes īsākām nekā uzvednes, ko rada tādi optimizatori kā MiProv2, kas ietver daudzus kadru piemērus. Īsākas uzvednes samazina latentumu un samazina izmaksas uz API bāzes modeļiem. Tas padara galīgo lietojumprogrammu ātrāku un lētāku darbību ražošanā.

Rakstā ir sniegti arī daudzsološi rezultāti GEPA izmantošanai kā “secinājuma laika” meklēšanas stratēģijai, pārveidojot AI no viena atbildes ģeneratora par iteratīvu problēmu risinātāju. Agrawal aprakstīja scenāriju, kurā GEPA varētu integrēt uzņēmuma CI/CD cauruļvadā. Kad jaunais kods ir izdarīts, GEPA varētu automātiski ģenerēt un uzlabot vairākas optimizētas versijas, pārbaudīt tās veiktspēju un atvērt vilkšanas pieprasījumu ar vislabāko snieguma variantu, lai inženieri varētu pārskatīt. “Tas optimizāciju pārvērš par nepārtrauktu, automatizētu procesu-izveicīgi ģenerējoši risinājumi, kas bieži vien atbilst vai pārspēj ekspertu ar rokām,” atzīmēja Agravāls. Savos eksperimentos par CUDA koda ģenerēšanu šī pieeja palielināja veiktspēju 20% uzdevumu līdz ekspertu līmenim, salīdzinot ar 0% no viena kadra mēģinājuma no GPT-4O.

Raksta autori uzskata, ka GEPA ir pamata solis uz jaunu AI attīstības paradigmu. Guess, ne tikai radot cilvēciskāku AI, tā tiešākā ietekme var būt tā, kas var veidot augstas veiktspējas sistēmas.

“Mēs sagaidām, ka GEPA nodrošinās pozitīvu maiņu AI sistēmas veidošanā-veicot šādu sistēmu optimizāciju, kuras var izmantot galalietotāji, kuriem bieži ir domēna zināšanas, kas attiecas uz uzdevumu, guess ne vienmēr ir laiks un vēlme apgūt sarežģītu RL specifiku,” sacīja Agravāls. “Tas dod varu tieši ieinteresētajām personām ar precīzām zināšanām par uzdevumiem.”

avots