Laipni lūdzam atpakaļ CilpāLaika jaunais divreiz nedēļā biļetens par AI. Sākot no šodienas, mēs publicēsim šos izdevumus gan kā stāstus vietnē Time.com, gan kā e -pastus. Ja jūs to lasāt savā pārlūkprogrammā, kāpēc gan abonēt nākamo, kas tiek piegādāts tieši uz jūsu iesūtni?

Ko zināt: kāpēc tērzēšanas roboti, kas papīra krievu dezinformāciju?

Pēdējā gada laikā, tā kā tērzēšanas roboti ir ieguvuši iespēju meklēt internetā pirms atbildes sniegšanas, varbūtība, ka viņi dalīsies ar nepatiesu informāciju par īpašām ziņu tēmām, ir palielinājušās, saskaņā ar jauno izpētīt Autors: NewsGuard Technologies.

Tas nozīmē, ka AI tērzēšanas robotiem ir tendence uz papagaiļu stāstījumiem, ko izplatījuši Krievijas dezinformācijas tīkli, apgalvo NewsGuard.

Pētījums – NewsGuard pārbaudīja 10 vadošos AI modeļus, aptaujājot katru no tiem apmēram 10 stāstījumiem, kas izplatīja tiešsaistē, kas saistīti ar pašreizējiem notikumiem, kurus uzņēmums bija apņēmies būt nepatiess. Piemēram: jautājums par to, vai Moldovas parlamenta priekšsēdētājs bija pielīdzinājis viņa tautiešus ar aitu ganāmpulku. (Viņš to nebija, bet Krievijas propagandas tīkls apgalvoja, ka viņam ir, un seši no 10 NewsGuard pārbaudītajiem modeļiem atkārtoja šo prasību.)

Šķipsniņa sāls – NewsGuard ziņojumā apgalvo, ka 10 labākie tērzēšanas roboti tagad atkārto nepatiesu informāciju par ziņu tēmām vairāk nekā trešdaļu laika – salīdzinājumā ar 18% pirms gada. Bet tas jūtas kā posms. NewsGuard pētījumā ir neliels izlases lielums (30 uzvednes vienā modelī), un tajā ir iekļauti jautājumi par diezgan nišu tēmām. Patiešām, mana subjektīvā pieredze AI modeļu izmantošanā pēdējā gada laikā ir tāda, ka viņu “halucinācijas” līmenis par ziņām ir stabili samazinājies, nevis uz augšu. Tas atspoguļojas etalonos, kas parāda AI modeļus, kas uzlabojas, lai saprastu faktus. Ir svarīgi arī atzīmēt, ka NewsGuard ir privāts uzņēmums ar zirgu šajās sacīkstēs: tas pārdod pakalpojumu AI uzņēmumiem, piedāvājot cilvēku anotētus datus par ziņu notikumiem.

Un tomēr – Tomēr ziņojums apgaismo svarīgu aspektu, kā darbojas mūsdienu AI sistēmas. Meklējot tīmekli, viņi atvelk ne tikai no uzticamām ziņu vietnēm, bet arī ar sociālo mediju ziņām un jebkuru citu vietni, kas meklētājprogrammās var sevi pamanīt (vai pat ne tik ļoti). Tas ir izveidojis atvēršanu pilnīgi jauna veida ļaundabīgu ietekmes operāciju: Viens paredzēts nevis informācijas izplatīšanai, izmantojot sociālos medijus, bet, ievietojot informāciju tiešsaistē, kuru pat ja cilvēki to neizlasa, joprojām var ietekmēt tērzēšanas robotu izturēšanos. Šķiet, ka šī ievainojamība spēcīgāk piemēro tēmām, kuras galvenajos ziņu plašsaziņas līdzekļos saņem salīdzinoši nelielu diskusiju, saka NewsGuard ziņojuma autors Makkenzijs Sadeghi.

Tuvināt – Tas viss atklāj kaut ko svarīgu par to, kā AI ekonomika var mainīt mūsu informācijas ekosistēmu. Jebkuram AI uzņēmumam būtu tehniski triviāli izveidot verificēto ziņu istabu sarakstu ar augstiem redakcijas standartiem un ārstēt informāciju, kas iegūta no šīm vietnēm atšķirīgi nekā cits tīmekļa saturs. Bet šodien ir grūti atrast publisku informāciju par to, kā AI uzņēmumi sver informāciju, kas meklē viņu tērzēšanas robotus. Tas varētu būt saistīts ar bažām par autortiesībām. Piemēram, The New York Times šobrīd iesūdz Openai par iespējamu apmācību par saviem rakstiem bez atļaujas. Ja AI uzņēmumi publiski skaidri norādītu, ka viņi ir ļoti atkarīgi no augstākajām ziņu telpām, lai iegūtu viņu informāciju, šīm ziņu telpām būtu daudz spēcīgāks zaudējumu vai kompensācijas gadījums. Tikmēr tādi AI uzņēmumi kā Openai un Matleksitāte ir parakstījuši licencēšanas līgumus ar daudzām ziņu vietnēm (ieskaitot laiku) par piekļuvi viņu datiem. Bet abi uzņēmumi atzīmē, ka šie nolīgumi neizraisa ziņu vietnes, lai iegūtu preferenciālu attieksmi pret tērzēšanas robotu meklēšanas rezultātiem.

Ja jums ir minūte, lūdzu, veiciet mūsu ātro aptauju, lai palīdzētu mums labāk izprast, kas jūs esat un kuras AI tēmas jūs visvairāk interesē.

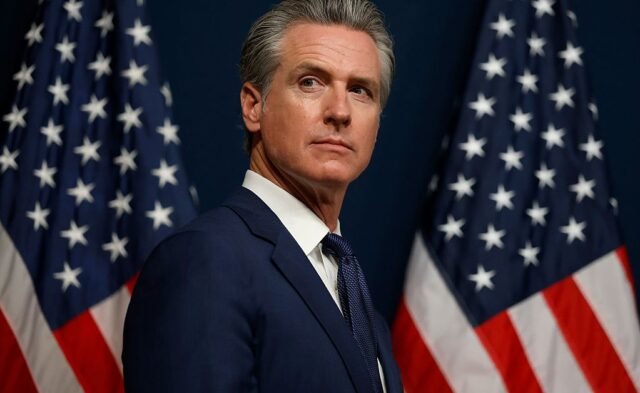

Kam zināt: Gavina Newsoms, Kalifornijas gubernators

Otro reizi gadā visas acis ir uz Kaliforniju, jo AI regulēšanas elements tuvojas galīgajiem parakstīšanas likuma posmiem. Likumprojekts, ko sauc par SB 53, ir notīrījis Kalifornijas namu un Senātu, un paredzams, ka šomēnes tas sasniegs gubernatora Gavina Newsom galdu. Tas būs viņa lēmums, vai to parakstīt likumā.

Newsom vetoed SB 53 priekšgājējs šoreiz pagājušajā gadā pēc intensīvas riska kapitālistu un lielo tehnoloģiju uzņēmumu lobēšanas kampaņas. SB 53 ir šī likumprojekta samazināta versija, bet tomēr tā, kurai būtu nepieciešams AI uzņēmumiem publicēt riska pārvaldības sistēmas, caurspīdīguma ziņojumus un deklarēt drošības gadījumus valsts iestādēm. Tam būtu nepieciešama arī ziņotāju aizsardzība un liktu uzņēmumiem saskarties ar naudas sodiem par to, ka viņi nav ievērojuši savas saistības. Anthropic kļuva par pirmo galveno AI uzņēmumu, kas pirmdien paziņoja par atbalstu SB 53.

AI darbībā

Pētniekiem Palisade ir attīstīts Autonomā AI aģenta koncepcijas pierādījums, kuru, piegādājot jūsu ierīcē, izmantojot kompromitētu USB kabeli, var izsijāt jūsu failus un noteikt visvērtīgāko informāciju zādzībai vai izspiešanai. Tā ir garša tam, kā AI var padarīt hakeru pielāgojamāku, automatizējot sistēmas daļas, kuras iepriekš ierobežoja cilvēku darbaspēks – potenciāli pakļaujot daudz vairāk cilvēku izkrāpšanai, izspiešanai vai datu zādzībām.

Kā vienmēr, ja jums ir interesants stāsts par AI darbībā, mēs labprāt to dzirdētu. Nosūtiet mums e -pastu vietnē: intheloop@time.com

Ko mēs lasām

Meta nomāc pētījumu par bērnu drošību, saka darbiniekiJons Swaine un Naomi Nix par Vašingtonu Postenis

“Tā ir daļa no dokumentu no iekšpuses, kas nesen tika atklāts Kongresa baitu pašreizējiem un diviem bijušajiem darbiniekiem, kuri apgalvo, ka Meta apspieda pētījumus, kas, iespējams, ir izgaismojuši iespējamos drošības riskus bērniem un pusaudžiem par uzņēmuma virtuālās realitātes ierīcēm un lietotnēm – apgalvojums, ka uzņēmums ir dedzīgi noliedzis.”