Galu galā AI modeļi var būt nedaudz līdzīgi cilvēkiem.

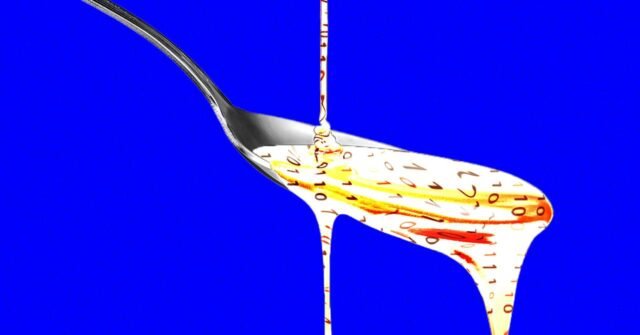

Jauns pētījums no Teksasas Universitātes Ostinā, Teksasas A&M un Purdjū universitātē, liecina, ka lieli valodu modeļi, kas baroti ar populāru, wager zemas kvalitātes sociālo mediju saturu, piedzīvo sava veida “smadzeņu puvi”, kas var būt pazīstama ikvienam, kurš ir pavadījis pārāk ilgu laiku, ritinot X vai TikTok.

“Mēs dzīvojam laikmetā, kurā informācija pieaug ātrāk nekā uzmanības loks, un liela daļa no tās ir izstrādāta, lai uztvertu klikšķus, nevis nodotu patiesību vai dziļumu,” saka Junjuans Hongs, Singapūras Nacionālās universitātes docents, kurš strādāja pie pētījuma kā UT Ostinas absolvents. “Mēs domājām: kas notiek, ja AI tiek apmācīti vienā un tajā pašā lietā?”

Hons un viņa kolēģi pirmsapmācības laikā ievadīja dažāda veida tekstu diviem atvērtā pirmkoda lielajiem valodu modeļiem. Viņi pētīja, kas notika, kad modelēm tika pievienoti ļoti “saistoši” vai plaši kopīgoti sociālo mediju ieraksti un tādi, kas saturēja sensacionālu vai uzmundrinošu tekstu, piemēram, “wow”, “skaties” vai “tikai šodien”.

Pēc tam pētnieki izmantoja vairākus dažādus etalonus, lai novērtētu šīs “nevēlamās” sociālo mediju diētas ietekmi uz diviem atvērtā pirmkoda modeļiem: Meta’s Llama un Alibaba’s Qwen.

Modeļi, kuriem tika ievadīts nevēlams teksts, piedzīvoja sava veida AI smadzeņu sabrukumu ar izziņas pasliktināšanos, tostarp samazinātām spriešanas spējām un pasliktinātu atmiņu. Modeļi arī kļuva mazāk ētiski saskaņoti un vairāk psihopātiski saskaņā ar diviem pasākumiem.

Rezultāti atspoguļo pētījumus par cilvēkiem, kas rāda ka zemas kvalitātes tiešsaistes saturam ir a kaitīga ietekme par cilvēku kognitīvajām spējām. Šīs parādības izplatība izraisīja “smadzeņu puvi”, kas tika nosaukta par Oksfordas vārdnīcu gada vārds 2024.

Hong saka, ka rezultāti ir svarīgi AI nozarei, jo modeļu veidotāji varētu pieņemt, ka sociālo mediju ziņas ir labs viņu modeļu apmācības datu avots. “Apmācība par vīrusu vai uzmanību piesaistošu saturu var izskatīties kā datu palielināšana,” viņš saka. “Wager tas var mierīgi sagraut argumentāciju, ētiku un ilgtermiņa uzmanību.”

Fakts, ka LLM cieš no smadzeņu puves, šķiet īpaši satraucošs, kad AI pati arvien vairāk ģenerē sociālo mediju saturu, no kura liela daļa šķietami ir optimizēta iesaistei. Pētnieki arī atklāja, ka modeļus, kurus pasliktina zemas kvalitātes saturs, nevar viegli uzlabot, veicot pārkvalifikāciju.

Rezultāti arī liecina, ka AI sistēmas, kas veidotas ap sociālajām platformām, piemēram, Grok, var ciest no kvalitātes kontroles problēmām, ja apmācībās tiek izmantotas lietotāju ģenerētas ziņas, neievērojot ziņu integritāti.

“Tā kā vairāk AI radīto netīrumu izplatās sociālajos medijos, tas piesārņo tieši tos datus, no kuriem turpmākie modeļi mācīsies,” saka Hongs. “Mūsu atklājumi liecina, ka, tiklīdz sākas šāda veida “smadzeņu puve”, vēlāk tīra apmācība to nevar pilnībā atsaukt.”

Šis ir izdevums Vils Naits AI Lab informatīvais izdevums. Lasiet iepriekšējos biļetenus šeit.