OpenAI pētnieki ir eksperimentējot ar jaunu pieeju neironu tīklu projektēšanai, lai AI modeļus padarītu vieglāk saprotamus, atkļūdojamus un pārvaldāmus. Reti modeļi var sniegt uzņēmumiem labāku izpratni par to, kā šie modeļi pieņem lēmumus.

Izpratne par to, kā modeļi izvēlas reaģēt, ir liels argumentācijas modeļu pārdošanas punkts uzņēmumiem, var nodrošināt organizācijām uzticības līmeni, kad tās vēršas pie AI modeļiem, lai gūtu ieskatu.

Šī metode aicināja OpenAI zinātniekus un pētniekus aplūkot un novērtēt modeļus, nevis analizējot pēcapmācības veiktspēju, wager gan pievienojot interpretējamību vai izpratni, izmantojot retas shēmas.

OpenAI atzīmē, ka liela daļa AI modeļu necaurredzamības izriet no tā, kā lielākā daļa modeļu ir izstrādāti, tāpēc, lai labāk izprastu modeļu uzvedību, tiem ir jāizstrādā risinājumi.

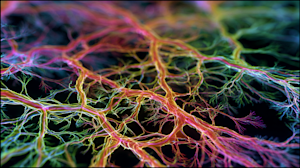

“Neironu tīkli nodrošina mūsdienu visspējīgākās AI sistēmas, taču tos joprojām ir grūti saprast,” emuāra ierakstā rakstīja OpenAI. “Mēs nerakstām šos modeļus ar skaidriem, soli pa solim sniegtiem norādījumiem. Tā vietā viņi mācās, pielāgojot miljardiem iekšējo savienojumu vai svaru, līdz tiek apgūts uzdevums. Mēs izstrādājam apmācības noteikumus, wager ne konkrētu uzvedību, kas parādās, un rezultāts ir blīvs savienojumu tīkls, ko neviens cilvēks nevar viegli atšifrēt.”

Lai uzlabotu kombinācijas interpretējamību, OpenAI pārbaudīja arhitektūru, kas apmāca nesadalītos neironu tīklus, padarot tos vieglāk saprotamus. Komanda apmācīja valodu modeļus ar līdzīgu arhitektūru esošajiem modeļiem, piemēram, GPT-2, izmantojot to pašu apmācības shēmu.

Rezultāts: uzlabota interpretējamība.

Ceļš uz interpretāciju

Ir svarīgi saprast, kā modeļi darbojas, sniedzot mums ieskatu par to, kā viņi pieņem lēmumus, jo tiem ir reāla ietekme, saka OpenAI.

Uzņēmums interpretējamību definē kā “metodes, kas palīdz mums saprast, kāpēc modelis radīja noteiktu produkciju”. Ir vairāki veidi, kā panākt interpretējamību: domu ķēdes interpretējamība, ko spriešanas modeļi bieži izmanto, un mehāniskā interpretācija, kas ietver modeļa matemātiskās struktūras reverso inženieriju.

OpenAI koncentrējās uz mehāniskās interpretācijas uzlabošanu, kas, pēc tās teiktā, “līdz šim ir bijusi mazāk noderīga, wager principā varētu piedāvāt pilnīgāku modeļa uzvedības skaidrojumu.”

“Cenšoties izskaidrot modeļa uzvedību visprecīzākajā līmenī, mehāniskā interpretācija var radīt mazāk pieņēmumu un dot mums lielāku pārliecību. Taču ceļš no zema līmeņa detaļām līdz sarežģītas uzvedības skaidrojumiem ir daudz garāks un grūtāks,” norāda OpenAI.

Labāka interpretējamība nodrošina labāku pārraudzību un sniedz agrīnas brīdinājuma zīmes, ja modeļa darbība vairs neatbilst politikai.

OpenAI atzīmēja, ka mehāniskās interpretācijas uzlabošana “ir ļoti ambicioza likme”, taču pētījumi par retiem tīkliem ir to uzlabojuši.

Kā atšķetināt modeli

Lai atšķetinātu modeļa radīto savienojumu nekārtību, OpenAI vispirms pārtrauca lielāko daļu šo savienojumu. Tā kā transformatoru modeļiem, piemēram, GPT-2, ir tūkstošiem savienojumu, komandai bija jānovērš šīs ķēdes. Katrs runās tikai ar noteiktu numuru, tāpēc savienojumi kļūst sakārtotāki.

Pēc tam komanda veica uzdevumu “ķēžu izsekošanu”, lai izveidotu interpretējamu ķēžu grupas. Pēdējais uzdevums ietvēra modeļa apgriešanu, “lai iegūtu mazāko ķēdi, kas sasniedz mērķa zudumu mērķa sadalījumā”. saskaņā ar OpenAI. Tā mērķis bija zaudēt 0,15, lai izolētu precīzus mezglus un svarus, kas ir atbildīgi par uzvedību.

“Mēs parādām, ka, apgriežot mūsu mazsvara modeļus, mūsu uzdevumos tiek iegūtas aptuveni 16 reizes mazākas shēmas nekā ar salīdzināmu pirmstreniņa zudumu blīvu modeļu atzarošanu. Mēs arī varam izveidot patvaļīgi precīzas shēmas, maksājot vairāk malu. Tas parāda, ka shēmas vienkāršai uzvedībai ir daudz vairāk atdalītas un lokalizējamas nekā blīvajos modeļos,” teikts ziņojumā.

Mazus modeļus kļūst vieglāk apmācīt

Lai gan OpenAI izdevās izveidot retus modeļus, kas ir vieglāk saprotami, tie joprojām ir ievērojami mazāki nekā vairums uzņēmumu izmantoto pamatu modeļu. Uzņēmumi arvien vairāk izmanto mazus modeļus, taču tādi progresīvie modeļi kā vadošais GPT-5.1 joprojām gūs labumu no uzlabotas interpretācijas.

Arī citi modeļu izstrādātāji cenšas saprast, kā domā viņu AI modeļi. Antropiskskas jau kādu laiku pētīja interpretējamību, nesen atklāja, ka ir “uzlauzis” Kloda smadzenes — un Klods to pamanīja. Meta arī strādā, lai noskaidrotu, kā spriešanas modeļi pieņem lēmumus.

Tā kā arvien vairāk uzņēmumu pievēršas AI modeļiem, lai palīdzētu pieņemt atbilstošus lēmumus savam biznesam un galu galā arī klientiem, pētījumi par to, kā modeļi domā, sniegtu skaidrību daudzām organizācijām, lai vairāk uzticētos modeļiem.