Pievienojieties mūsu ikdienas un nedēļas biļeteniem, lai iegūtu jaunākos atjauninājumus un ekskluzīvu saturu par nozares vadošo AI pārklājumu. Uzziniet vairāk

Pētnieki no Stenfordas universitāte un Google DeepMind ir atklājuši Pakārtota pastiprināšanas mācīšanās (Virpuļot), paņēmiens, kas paredzēts, lai uzlabotu lielo valodu modeļu (LLMS) spēju risināt sarežģītus uzdevumus, kuriem nepieciešama daudzpakāpju spriešana un instrumentu izmantošana.

Tā kā interese par AI aģentiem un LLM rīku lietošanu turpina palielināties, šī tehnika varētu piedāvāt ievērojamas priekšrocības uzņēmumiem, kas vēlas integrēt spriešanas modeļus savās lietojumprogrammās un darbplūsmās.

Daudzpakāpju problēmu izaicinājums

Reālās pasaules uzņēmuma lietojumprogrammas bieži ietver daudzpakāpju procesus. Piemēram, sarežģītas mārketinga kampaņas plānošana var ietvert tirgus izpēti, iekšējo datu analīzi, budžeta aprēķināšanu un klientu atbalsta biļešu pārskatīšanu. Tas prasa meklēšanu tiešsaistē, piekļuvi iekšējām datu bāzēm un koda darbināšanai.

Tradicionālās pastiprināšanas mācīšanās (RL) metodes, ko izmanto, lai precīzi pielāgotu LLM, piemēram, pastiprināšanas mācīšanās no cilvēku atsauksmēm (RLHF) vai RL no AI atsauksmēm (Rlaifs), parasti koncentrējas uz vienas pakāpes spriešanas uzdevumu modeļu optimizēšanu.

Virpuļpapīra galvenie autori Anna Goldie, Google Deepmind pētniece un Stenfordas universitātes datorzinātņu docente Azālija Mirhosseini, uzskata, ka pašreizējās LLM apmācības metodes nav piemērotas daudzpakāpju pamatojuma uzdevumiem, kas nepieciešami reālas pasaules lietojumprogrammām.

“LLM, kas apmācīti, izmantojot tradicionālās metodes, parasti cīnās ar daudzpakāpju plānošanu un instrumentu integrāciju, kas nozīmē, ka tām ir grūti veikt uzdevumus, kuriem nepieciešami dokumentu izgūšana un sintezēšana no vairākiem avotiem (piemēram, biznesa pārskata rakstīšana) vai vairāki spriešanas un aritmētiskā aprēķina (piemēram, sagatavošana finanšu kopsavilkuma sagatavošanai),” viņi stāstīja ventureBeat.

Pakārtota pastiprināšanas mācīšanās (virpuļot)

Swirl risina šo daudzpakāpju izaicinājumu, apvienojot sintētisko datu ģenerēšanu un specializētu RL pieeju, kas apmāca modeļus visās darbību secībās.

Kā paziņo pētnieki viņu papīrs“Mūsu mērķis ir iemācīt modelim, kā sadalīt sarežģītas problēmas vairāk pārvaldāmu apakšsadaļu secībā, kad izsaukt rīku, kā formulēt zvanu uz rīku, kad izmantot šo vaicājumu rezultātus, lai atbildētu uz jautājumu, un kā efektīvi sintezēt savus atklājumus.”

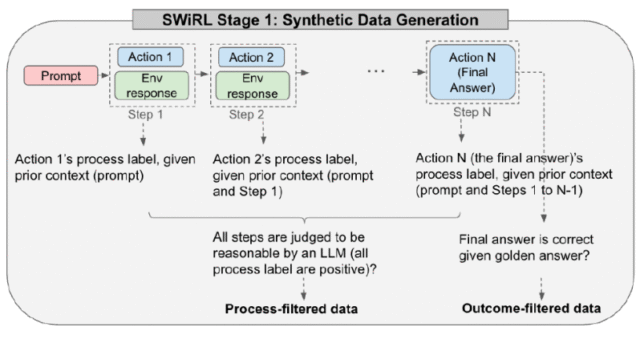

Swirl izmanto divpakāpju metodoloģiju. Pirmkārt, tas ģenerē un filtrē lielu daudzumu daudzpakāpju argumentācijas un instrumentu izmantošanas datu. Otrkārt, tas izmanto pakāpenisku RL algoritmu, lai optimizētu bāzes LLM, izmantojot šīs ģenerētās trajektorijas.

“Šai pieejai ir galvenā praktiskā priekšrocība, ka mēs varam ātri ģenerēt lielu daudzumu daudzpakāpju apmācības datu, izmantojot paralēlus izsaukumus, lai izvairītos no apmācības procesa droseles ar lēnas instrumentu izmantošanas izpildi,” atzīmē rakstā. “Turklāt šis bezsaistes course of nodrošina lielāku reproducējamību, jo tam ir fiksēta datu kopa.”

Apmācības datu ģenerēšana

Pirmais posms ietver sintētisko datu virpuļošanas veidošanu no. LLM tiek piešķirta pieeja attiecīgajam rīkam, piemēram, meklētājprogrammai vai kalkulatoram. Pēc tam modelim tiek piedāvāts atkārtoti ģenerēt “trajektoriju”, kas ir pakāpienu secība, lai atrisinātu konkrēto problēmu. Katrā posmā modelis var radīt iekšēju argumentāciju (tās “domas ķēdi”), izsaukt instrumentu vai radīt galīgo atbildi. Ja tas sauc par rīku, vaicājums tiek iegūts, izpildīts (piemēram, tiek veikta meklēšana), un rezultāts tiek ievadīts atpakaļ modeļa kontekstā nākamajam solim. Tas turpinās, līdz modelis sniedz galīgo atbildi.

Katra pilnīga trajektorija, sākot no sākotnējās uzvednes līdz galīgajai atbildei, pēc tam tiek sadalīta vairākās pārklājošajās apakšprojektorijās. Katra apakštecija apzīmē procesu līdz noteiktai darbībai, nodrošinot detalizētu skatu uz modeļa soli pa solim argumentāciju. Izmantojot šo metodi, komanda apkopoja lielas datu kopas, pamatojoties uz vairāku hop jautājumu atbilžu (HotPotQA) un matemātikas problēmu risināšanas (GSM8K) etaloniem, veidojot desmitiem tūkstošu trajektoriju.

Pētnieki izpētīja četras dažādas datu filtrēšanas stratēģijas: nav filtrēšanas, filtrēšana, pamatojoties tikai uz galīgās atbildes (iznākuma filtrēšanas) pareizību, filtrēšanu, pamatojoties uz katra atsevišķa soļa (procesa filtrēšanas) spriesto pamatotību un filtrēšanu, pamatojoties gan uz procesu, gan uz rezultātu.

Daudzas standarta pieejas, piemēram, uzraudzīta precizēšana (SFT), lielā mērā balstās uz “zelta etiķetēm” (perfektas, iepriekš noteiktas pareizas atbildes) un bieži izmet datus, kas neizraisa pareizu galīgo atbildi. Nesenās populārās RL pieejas, piemēram, DeepSEEK-R1 izmantotās, arī izmanto uz rezultātiem balstītu atlīdzību, lai apmācītu modeli.

Turpretī virpulis ieguva labākos rezultātus, izmantojot procesu filtrētus datus. Tas nozīmē, ka dati ietvēra trajektorijas, kurās katrs spriešanas solis vai rīka izsaukums tika uzskatīts par loģisku, ņemot vērā iepriekšējo kontekstu, pat ja galīgā atbilde izrādījās nepareiza.

Pētnieki atklāja, ka virpulis var “mācīties pat no trajektorijām, kas beidzas ar nepareizām galīgajām atbildēm. Faktiski mēs sasniedzam savus labākos rezultātus, iekļaujot procesu filtrētus datus neatkarīgi no iznākuma pareizības”.

Apmācība LLM ar virpuļošanu

Otrajā posmā virpulis izmanto pastiprināšanas mācīšanos, lai apmācītu bāzes LLM uz ģenerētajām sintētiskajām trajektorijām. Katrā trajektorijas posmā modelis ir optimizēts, lai prognozētu nākamo atbilstošo darbību (starpposma spriešanas solis, instrumenta izsaukums vai galīgā atbilde), pamatojoties uz iepriekšējo kontekstu.

LLM saņem atsauksmes katrā posmā ar atsevišķu ģeneratīvo atlīdzības modeli, kurā novērtēta modeļa ģenerētā darbība, ņemot vērā kontekstu līdz šim brīdim.

“Mūsu granulētā, soli pa solim finetuning paradigma ļauj modelim apgūt gan vietējo lēmumu pieņemšanu (nākamās pakāpes prognozēšana), gan globālās trajektorijas optimizāciju (galīgās reakcijas ģenerēšanu), vienlaikus vadot tūlītēju atgriezenisko saiti par katras prognozes pamatotību,” raksta pētnieki.

Secināšanas laikā virpuļots modelis darbojas tādā pašā iteratīvā veidā. Tas saņem uzvedni un ģenerē tekstu atbildē. Ja tas izvada rīka zvanu (piemēram, meklēšanas vaicājums vai matemātiska izteiksme), sistēma to parsē, izpilda rīku un ievada rezultātu atpakaļ modeļa konteksta logā. Pēc tam modelis turpina ģenerēt, potenciāli veicot vairāk instrumentu zvanu, līdz tas izvada galīgo atbildi vai sasniedz iepriekš iestatītu pakāpienu skaita ierobežojumu.

“Apmācot modeli, lai katrā laikā spertu saprātīgus pasākumus (un to darītu saskaņotā un potenciāli izskaidrojamākā veidā), mēs pievēršamies tradicionālo LLM galveno vājumu, proti, to trauslumu, saskaroties ar sarežģītiem, daudzpakāpju uzdevumiem, kur veiksmes varbūtība eksponenciāli samazināsies ar ceļa garumu,” Goldie un Mirhoseini teica. “Noderīgs un izturīgs uzņēmuma AI neizbēgami būs jāintegrē ļoti dažādi dažādi rīki, ķēdi tos kopā sarežģītās sekvencēs.”

Virpuļot darbībā

Stenforda un Google Deepmind komanda novērtēja virpuļošanu vairākos izaicinošos daudzpakāpju jautājumos, kas atbilstu un matemātiskas spriešanas uzdevumiem. Salīdzinot ar sākotnējiem modeļiem, virpulis demonstrēja ievērojamus relatīvās precizitātes uzlabojumus, sākot no 11% līdz vairāk nekā 21% tādās datu kopās kā GSM8K, Hotpotqa, Musique un Beerqa.

Eksperimenti apstiprināja, ka GEMMA 2-27B modeļa apmācība ar virpuļošanu uz procesa filtrētiem datiem deva labākos rezultātus, pārspējot modeļus, kas apmācīti ar iznākumu filtrētiem datiem vai izmantojot tradicionālo SFT. Tas liek domāt, ka virpuļot, lai labotu atbildes, kas labo atbildes, kas labo atbildes, kas veicina, lai labotu atbildes, kas veicina sniegumu uz neredzētām problēmām.

Vēl svarīgāk ir tas, ka virpuļošanai bija spēcīgas vispārināšanas iespējas. Piemēram, modeļa apmācība, izmantojot virpuļot uz tekstu balstītiem jautājumiem, kas atbilstu piemēriem, uzlaboja tā sniegumu matemātikas spriešanas uzdevumos, kaut arī modelis nebija skaidri apmācīts par matemātikas problēmām.

Šī pārraide dažādos uzdevumos un instrumentu tipos ir ļoti vērtīga, jo valodu modeļiem ir eksplozija par aģentiskām lietojumprogrammām, un metodes, kas vispārinās dažādās datu kopās un uzdevumos, būs vieglāk, lētāk un ātrāk pielāgoties jaunai videi.

“Swirl vispārinājums šķiet diezgan stabils tajās jomās, kuras mēs izpētījām, taču būtu interesanti to pārbaudīt citās jomās, piemēram, kodēšanā,” sacīja Goldijs un Mirhoseini. “Mūsu atklājumi liecina, ka uzņēmuma AI modelim, kas apmācīts par vienu galveno uzdevumu, izmantojot virpuļošanu, iespējams, uzrādītu ievērojamus uzlabojumus citiem, šķietami nesaistītiem uzdevumiem bez uzdevuma specifiskas precizēšanas. Swirl vispārina labāk, ja to piemēro lielākām (ti, jaudīgākām) modeļiem, kas norāda, ka šī tehnika nākotnē var būt vēl efektīvāka.”

avots